SEO网站优化,网站日志数据分析整理的重要性

- 出名SEO

- 数据分析

- 2014-12-28

- 36

赞 (9)

赞 (9)

对于从事SEO优化工作的人都知道网站日志文件分析在整个SEO工作中非常重要,可能有一些SEO人员说“没什么用”,可见技术水平参差不齐,很多优化人员充其量是外链发布员或编辑人员,距离SEO整个岗位相差甚远,甚至没有入门,但认为自己属于SEO,暂且不讲,网站日志分析是做SEO工作的基础,尤其在大中型网站中极为重要,阿里巴巴前任SEO负责人国平曾说过,不需要网站日志分析做工作的SEO都是“世外高人”,很有讽刺意义。

日志分析与流量软件分析的差别:

从SEO的角度来说,两者的相同点:日志分析和流量软件分析都能分析出网站各种流量、受访页情况、关键字数据等

不同点:

日志分析往往不能分析当前的流量数据;

常见的流量分析软件不能分析出搜索引擎爬虫数据;

常见的流量分析软件不会分析错误链接等数据;

下面分析下网站日志分析能够给SEO工作带来什么?

网站日志分析可以解决网站中频道间收录不均衡的问题

当对笔者在某个企业做SEO工作时,其中该企业的运营总监(主要负责网站SEO)向笔者咨询网站收录一直提升不上去是什么原因,于是对该网站进行初步的浏览检查,和笔者的同事运营总监一样,没有找到任何原因,感觉更方面都做的还不错,笔者就让他发一下最近几天搜索引擎抓取网页日志记录。

通过对网站日志数据分析,几分钟的时间就找到了造成网站收录问题的根本原因。原来百度spider每天把80%的抓取量分布在其中的两个频道下,而这两个频道数据非常少,同比其他频道,那些数据量大,内容更新频繁的重要频道的日抓取量不到10%,有的甚至才几次的抓取,经过分析,原来百度spider在抓取量过多的两个频道中出现了“黑洞”,也就是死循环,耗去了大量的资源,造成网站频道间网页收录不均衡,内容量比较大的网页收录很少,因为百度蜘蛛抓取的很少。

网站日志分析可以解决重复抓取问题

无论是百度还是谷歌,都是通过编程技术模式来实现网页下载的,通过多线程的技术处理上亿网页抓取问题。既然是程序就会有bug,没有十全十美的技术,加上网页端html代码不标准,几乎没有网页完全符合w3c标准的,另外网页加载速度造成字节下载时截断等原因,会造成搜索引擎对单个网页或某一部分特征网页过度重复抓取问题存在,从而影响到网站整体收录问题。

那么,通过日志文件筛选出抓取次数过高的前几位URL或某个频道的URL,通过该特征抓取量与实际网页对比,分析是否存在问题。

网站日志分析可以发现网页异常返回码

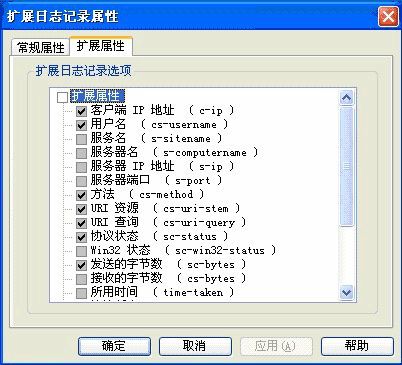

搜索引擎在访问一个网页时,正常的状态码是200,非200状态码都是存在问题的,通过日志文件,我们可以利用网站日志分析工具(网上有很多相关工具),如果有技术,可以利用技术对日志文件进行操作,筛选非200状态码页面是什么原因造成的。